SVVR 2017 - 2日目

SVVR記事の2日目です。この日は多くの展示を体験し、講演も聴講しました。

Silicon Valley Virtual Reality というイベントのために、アメリカはカリフォルニア州のサンノゼに行ってきました。

目次 - 2日目

- 朝

- 展示:OptiTrack

- 展示:Leap Motion

- 展示:スタンドアローンのヘッドセット、Pico

- 展示:ハンドトラッキングの uSens

- 展示:KYOTO VR

- 展示:Contact CI

- 講演:アイトラッキングの tobii

- 講演:深度カメラ使って、VR の中に MR を容易に実現する

- Adobe 訪問

- 夕食

朝

朝、シャワーを浴びて9時スタートの皆さんを見送る。皆、前日に買った食料で過ごしていた。

自分はというと、前日過ごして不足を感じたものを買いに出かけた。服、シャンプー、飲み物、お菓子など。じっくり Safeways 全体を見られてよかった。無印はアレだな、ほぼ完全に日本。日本語のタグまんまのが多い。

展示:OptiTrack

非常に広い範囲で使用できるトラッキングシステム。VOID もこれらしい。ZERO LATENCY はどうだったかな?

写真で見ての通り、上から複数のカメラで撮影してトラッキングができる。ヘッドセットだけでなく、多くのカスタムデバイスを追跡できるのも売りだ。

展示のコンテンツは、ライフル的なもので飛んでくるペイントボールを撃ち落とすやつだった。結構楽しい。

だが実際のところ、かなり気になる遅延があり、Oculus や Vive のデフォルトのポジショントラッキングに慣れていると前世代といった印象。価格も考え合わせると採用できるところは限られるんじゃないだろうか。

気になる価格は、カメラ一台14万円弱からとなかなかの値段。

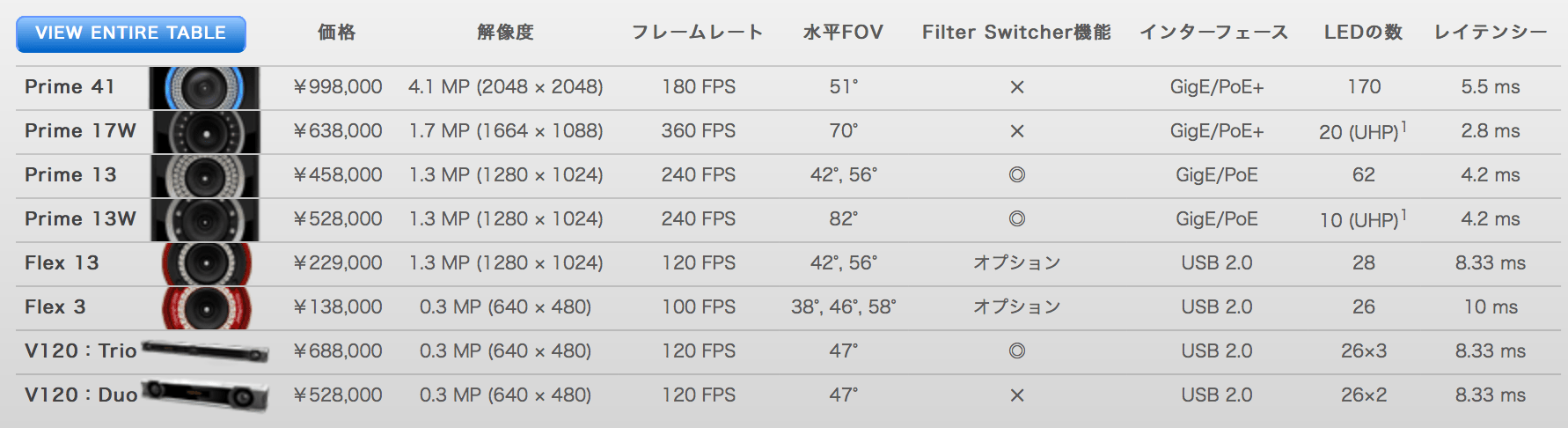

下記は執筆時点での公式サイトのキャプチャだ。カメラの容姿と、説明員さんが240FPSだと言っていた所から判断するに、Prime 13 シリーズのどちらかが展示されていたと予想されるが、上の写真に写っているだけでも7台、安いほうだったとしても 45万8千円 × 7台で 320万6千円となる。さらにトラッキング用のソフトも税込50万円を超えている。

VR ヘッドセットメーカーが安価に高品質なトラッキングシステムを実現して、Vive Tracker が好きなものをトラッキングできるシステムを(しかも1個12,500円で)実現した今、広大な領域での体験を作りたい需要以外では立つ瀬がないのではというのが個人的な感想だ。

展示:Leap Motion

みんな大好き Leap Motion。以前発表になっていた、モバイル用の製品がでもされていたので体験させてもらった。

感想としては、かなり良かった。PC と遜色なく滑らかに動き、遅延も少なく、トラッキング範囲は宣伝通り広大だった。前面に装着することで重量バランスは悪くなるが、短時間なら気になるほどではない。

Leap がこれまでソフトウェアの更新だけで凄まじい進化を遂げてきたこと考えると、イベント展示用に期待したい。

展示:スタンドアローンのヘッドセット、Pico

以前からスタンドアローンの VR ヘッドセットを作っているメーカー、Pico。第1世代はオレンジの筐体と初めから繋がっている処理部兼コントローラーが特徴の製品だったが、第2世代で Inside-out のポジショントラッキングに対応した。

Inside-out のポジショントラッキングとは、その名の通り内側(本体)から外側(外界)を見て自分の位置を計算する仕組みのことである。外にカメラを設置する必要がなく、本体だけで使えるのが魅力だ。

展示ではこれを体験することができたが、正直な所、精度はまだまだだと感じた。首を傾けると床が割と激しく上下する。深度センサーを搭載しているのか尋ねた所、RGB のみで処理しているとのことだった。その割にはなかなかだが、将来性があるのかはちょっとなんとも言えない。

その代わり、コンテンツが素晴らしかった。展示スペースと同じ広さの仮想空間に入り、スパイ映画さながらに赤い赤外線の光を避けて進んでいくというもので、正直とても面白かった。発売してほしい。

展示:ハンドトラッキングの uSens

こちらは Leap と似たような製品の uSens。後ろのパネルにはポジトラだとか MR だとかいろいろ書いているが、この日はハンドトラッキングのみ体験できた。

どれほどのものかと思ったが、これは残念ながらイマイチだった。手は出てくるが、遅延がすごい(体感でコンマ5秒くらい)し、フレームレートもかなり低かった。PC で使うと違うのかはわからないが、この日の展示に関しては残念な一品だった。

展示:KYOTO VR

京都の風景を VR 空間で再現しているスタートアップ。フォトグラメトリーで京都の美しい部分を切り取って体験できる。

展示では Oculus Rift が使用されており、ぱっと見の印象はとても綺麗なものの、よく作り込まれたVRコンテンツと変わらなかった。とは言え、これはKYOTO VR の瑕疵ではなく、とても細かく作られたコンテンツの底力を十分に楽しめるヘッドセットがまだないのが原因だろうと考えている。今後 VR ヘッドセットが高解像度化した時に、このコンテンツは一気に化ける可能性がある。

展示:Contact CI

Contact CI は、ハンドトラッキングとフォースフィードバックを行える手袋型デバイス。

手全体にフィードバックが得られそうだったので期待して待っていたが、ずっと不調が続いており、結局体験できなかった。

その代わり、他の人を見た感想を書いておく。まず、1人1人キャリブレーションが必要で、最低1分くらいかかる上に何度も失敗していた。キャリブレーションが終わっても現実の手と動きが一致しておらず、まだまだ改良が必要な段階のようだった。

講演:アイトラッキングの tobii

アイトラッキングで世界一の会社。公式ウェブサイトはこちら。

The Future of Eye Tracking というタイトルで講演していた。

エキスポの方で体験させてもらって、非常に良い精度で使えていたのもあって聴きに来た。

主にユーザーの操作体験を自然にすることに主眼を置いているとのことで、下記のようなユースケースを紹介していた。

Forveated Rendering

みなさんご存知、中心窩適応レンダリング。視線の先のみ高解像度に描画することで、レンダリング負荷を下げる。VRの高解像度化を早期に実現するために不可欠な技術。

True pupil position

瞳の位置を正しくする。アバターの目が視線の通りに動き、自然なコミュニケーションが可能になる。トランプをやっている時に視線で怪しい感じが分かったり。

User positioning

テレポートも自然にできる。行きたいところを見て、ボタンを押すだけ。今までは視線と言いながら首の動きで表現していたが、本当に視線を使うと楽で、高速で、自然な体験になる。

高速な選択

UI やターゲットの選択。頭を動かして標的を狙うのに比べて圧倒的に早い。視線で選択する方が圧倒的に自然。

石をボトルにぶつけるデモでは、ぶつけたいボトルを見ながら投げることで、自然にそのボトルに向かって行くような暗黙の補助ができる。

これによって、インテリジェントなインターフェースが実現できる。

ハンドコントローラーを使って操作する対象を、視線によって自然に選択できる。手を物体の位置まで持って行く必要がないのはとても良かった。

以上から、VR を真に没入的にするためにアイトラッキングが必要だとの見解を示していた。

Khronos Group と標準 API の制定に向けて協力しているとの発表があった。

色々なハードやOSへの対応については、みんなが思っているよりは多くのものに対応できるだろう。とのこと。

講演:深度カメラを使って、VR の中に MR を容易に実現する

OpenBroadcaster でソースを foreground, Green screen, background と構成し、処理する。

UE4 では紹介されたプラグインを入れるだけ。

残念ながら時差ぼけの限界がきてzzz。後で調べ直そう。

ちなみに時差ぼけは英語で jet lag.

I have terrible jet lag. omg…

Adobe 訪問

じゃんけんに勝って Adobe を訪問することになった(会場の目と鼻の先にある)。

夕食

メキシコ料理屋を訪ねて、他国の展示者も交わりディナー。ここは美味しかった!

2017年3月29日